Mixed Reality Forschung mit Köpfchen

Auf der weltweit größten Konferenz im Bereich Mensch-Maschine-Interaktion, der ACM CHI 2017 in Denver, stellte Prof. Dr. Jens Grubert seine aktuelle Arbeit zu Mixed Reality Displays vor. Es geht z.B. darum, wie mehrere mobile Geräte als ein durchgehendes Display fungieren können.

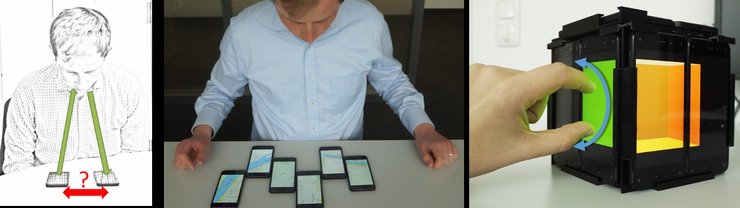

Im Beitrag „HeadPhones: Ad Hoc Mobile Multi-Display Environments through Head Tracking“ stellte Prof. Dr. Grubert Prototypen vor, die das spontane Zusammenstellen und Verorten von mehreren Smartphones oder Tablets zu einer großen Anzeigefläche möglich machen. Bisherige Arbeiten auf diesem Gebiet wiesen zahlreiche Nachteile auf. Zum Beispiel war es notwendig, dass eine externe Kamera in der Umgebung installiert wurde. Prof. Dr. Grubert erfand ein Verfahren, welches den Kopf des Nutzers als Bezugssystem nutzt. Die 3D-Position des Kopfes wird durch die Frontkameras der Smartphones erfasst. Somit wirkt sie als gemeinsamer Koordinatenursprung und erlaubt, die Lage der Geräte untereinander zu bestimmen. Dadurch lassen sich vielfältige Anwendungen außerhalb von Laborbedingungen realisieren, z.B. können Karten interaktiv und auf mehreren Displays angezeigt werden. Auch dreidimensionale Anzeigekonfigurationen, welche den Eindruck von holographischen Darstellungen erwecken, können so erreicht werden.

Bei der ACM Conference on Human Factors in Computing Systems (ACM CHI) sind jährlich über 3000 Teilnehmer. Mehr Informationen zum Projekt unter: http://mixedrealitylab.bplaced.net/headphones-en.html